Artificial IntelligenceCybersecurity

Un sistema per predire in anticipo i cyber attacchi

I sistemi di sicurezza di oggi di solito rientrano in una tra due categorie: umano o macchina. Le cosiddette “analyst-driven solutions” si basano su regole create da esperti in carne ed ossa perciò quegli attacchi che sfuggono alle regole potrebbero passare inosservati. Al contrario, gli approcci di apprendimento automatico di oggi si basano su “anomaly detection”, approccio il quale tende ad innescare falsi positivi che creano diffidenza verso il sistema e finiscono comunque per dover essere corretti dagli esseri umani.

Cosa succederebbe se ci fosse una soluzione che potesse unire questi due mondi? A che cosa somiglierebbe?

In una recente ricerca, i ricercatori del MIT Computer and Artificial Intelligence Laboratory (CSAIL) e la startup PatternEx dimostrano una piattaforma di intelligenza artificiale chiamato AI² per la previsione di attacchi informatici significativamente migliore rispetto ai sistemi esistenti e che incorpora il continuo contributo di esperti umani. (Il nome deriva dalla fusione delle parole artificial intelligence con ciò che i ricercatori chiamano “analyst intuition”).

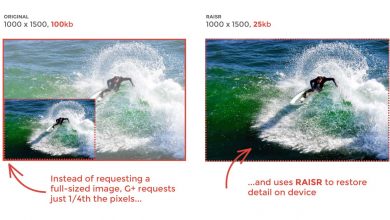

Il team di ricerca ha mostrato come AI² può rilevare l’85 percento degli attacchi, all’incirca tre volte meglio di precedenti benchmark, ma anche ridurre il numero di falsi positivi di un fattore 5. Il sistema è stato testato su 3,6 miliardi di segmenti di dati noti come “log lines”, che sono stati generati da milioni di utenti durante un periodo di tre mesi.

Per prevedere gli attacchi, AI² rileva attività sospette clusterizzando i dati in modelli significativi utilizzando algoritmi di machine-learning non supervisionati. A questo punto il sistema presenta le rilevazioni agli analisti umani che confermano se gli eventi sono attacchi reali, incorporando un feedback nei suoi modelli cercando di migliorarsi per la prossima serie di dati.

“Si può pensare al sistema come un analista virtuale”, dice il ricercatore CSAIL Kalyan Veeramachaneni, che ha sviluppato AI² con Ignacio Arnaldo, il chief data scientist di PatternEx ed ex post-dottorato CSAIL. “Il sistema genera continuamente nuovi modelli che è in grado di raffinare in appena un paio d’ore, il che significa che può migliorare le sue percentuali di rilevamento significativamente e rapidamente”.

Veeramachaneni ha presentato un paper sul sistema alla Conferenza Internazionale IEEE su Big Data Security a New York.

La creazione di sistemi di sicurezza informatica che fondono gli approcci supervisionati ed automatici è difficile, anche a causa dello sforzo richiesto per l’etichettatura manuale dei dati da sottoporre agli algoritmi.

Per esempio, diciamo che si desidera sviluppare un algoritmo di “vista computerizzata” in grado di differenziare fotografie di oggetti da fotografie di “non-oggetti” con elevata precisione. Prima di sottoporre al sistema i dati basteranno dei volontari umani che etichettino le foto come oggetti o non oggetti.

Per masse di dati riguardanti la sicurezza informatica invece, la persona media, ricercabile ad esempio su un sito di crowdsourcing come Amazon Mechanical Turk, semplicemente non ha gli skill per applicare etichette come “DDOS” o “exfiltration attacks’, dice Veeramachaneni. “C’è bisogno di esperti di sicurezza.”

Questo apre un altro problema: gli esperti sono occupati, e non possono passare tutto il giorno a revisionare risme di dati che sono stati segnalati come sospetti. Le aziende spesso rinunciano a piattaforme che hanno bisogno di troppo lavoro di mantenimento, quindi un sistema di apprendimento automatico efficace deve essere in grado di migliorare se stesso senza oberare di lavoro i suoi padroni umani.

L’arma segreta di AI² è che fonde insieme tre diversi metodi di apprendimento non supervisionato e poi mostra agli analisti soltanto i top eventi da etichettare. Successivamente costruisce un modello di sorveglianza in grado di perfezionarsi continuamente attraverso quello che il team chiama “continuous active learning system”.Col passare del tempo AI², migliora la capacità d’identificazione di attacchi reali, il che significa che già a pochi giorni dall’installazione l’analista dovrà occuparsi di etichettare non più di 30 o 40 eventi al giorno.

“Questo paper riunisce i punti di forza dell’intuizione umana e dell’apprendimento automatico, e riduce sia i falsi positivi che i falsi negativi”, spiega Nitesh Chawla, professore di Computer Science presso l’Università di Notre Dame. “Questa ricerca ha il potenziale per diventare una linea di difesa contro gli attacchi quali la frode, l’abuso di servizio e il furto di account,che sono le principali sfide poste oggigiorno.”

Il team dice che AI² può scalare a miliardi di righe di log al giorno, trasformando i dati minuto per minuto in diverse “caratteristiche”, o tipi distinti di comportamento che vengono poi considerati “normali” o “anormali “.

“Più attacchi il sistema rileva, più riceve i feedback dell’analista e migliora l’accuratezza delle previsioni future”, dice Veeramachaneni. “Questa interazione uomo-macchina crea uno stupendo effetto a cascata”.

Scopri come tradurre istantaneamente una conversazione.

Articolo originale: MIT News